Οι ανιχνευτές που λειτουργούν με τεχνητή νοημοσύνη είναι τα καλύτερα εργαλεία για τον εντοπισμό πλαστών βίντεο που δημιουργούνται από AI. Το Washington Post μέσω της Getty Images

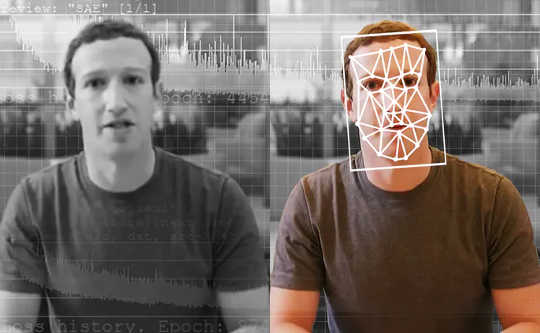

Ένας ερευνητής δημοσιογράφος λαμβάνει ένα βίντεο από έναν ανώνυμο πληροφοριοδότη. Δείχνει έναν υποψήφιο Πρόεδρο να παραδέχεται παράνομη δραστηριότητα. Είναι όμως αληθινό αυτό το βίντεο; Αν ναι, θα ήταν τεράστια είδηση – η σέσουλα μιας ζωής – και θα μπορούσε να αλλάξει εντελώς τις επερχόμενες εκλογές. Αλλά η δημοσιογράφος τρέχει το βίντεο μέσω ενός εξειδικευμένου εργαλείου, το οποίο της λέει ότι το βίντεο δεν είναι αυτό που φαίνεται. Στην πραγματικότητα, είναι ένα «deepfake», ένα βίντεο που δημιουργήθηκε με χρήση τεχνητής νοημοσύνης με βαθιά μάθηση.

Οι δημοσιογράφοι σε όλο τον κόσμο θα μπορούσαν σύντομα να χρησιμοποιήσουν ένα εργαλείο σαν αυτό. Σε λίγα χρόνια, ένα εργαλείο σαν αυτό θα μπορούσε ακόμη και να χρησιμοποιηθεί από όλους για να ξεριζώσει το ψεύτικο περιεχόμενο στις ροές των μέσων κοινωνικής δικτύωσης.

As ερευνητές που έχουν μελετήσει την ανίχνευση deepfake και αναπτύσσοντας ένα εργαλείο για τους δημοσιογράφους, βλέπουμε ένα μέλλον για αυτά τα εργαλεία. Δεν θα λύσουν όλα τα προβλήματά μας, ωστόσο, και θα είναι μόνο ένα μέρος του οπλοστασίου στον ευρύτερο αγώνα κατά της παραπληροφόρησης.

Το πρόβλημα με τα deepfakes

Οι περισσότεροι άνθρωποι ξέρουν ότι δεν μπορείς να πιστέψεις όλα όσα βλέπεις. Τις τελευταίες δύο δεκαετίες, οι έμπειροι καταναλωτές ειδήσεων έχουν συνηθίσει να βλέπουν εικόνες που χειραγωγούνται με λογισμικό επεξεργασίας φωτογραφιών. Τα βίντεο, όμως, είναι μια άλλη ιστορία. Οι σκηνοθέτες του Χόλιγουντ μπορούν να ξοδέψουν εκατομμύρια δολάρια σε ειδικά εφέ για να φτιάξουν μια ρεαλιστική σκηνή. Αλλά χρησιμοποιώντας deepfakes, ερασιτέχνες με εξοπλισμό υπολογιστών μερικών χιλιάδων δολαρίων και μερικές εβδομάδες για να ξοδέψετε, θα μπορούσαν να κάνουν κάτι σχεδόν εξίσου αληθινό στη ζωή.

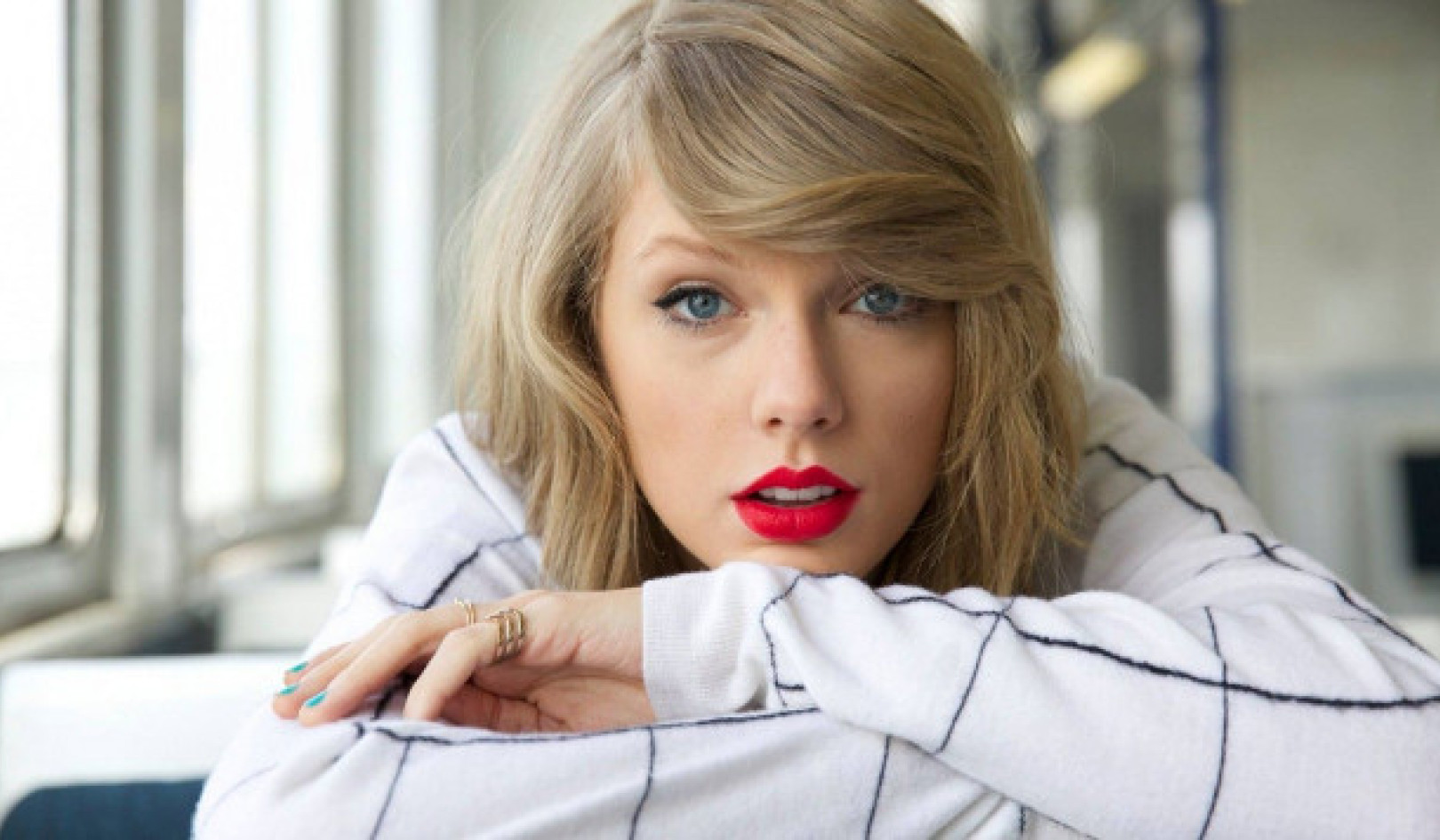

Τα Deepfakes καθιστούν δυνατό να βάλουμε ανθρώπους σε σκηνές ταινιών στις οποίες δεν ήταν ποτέ – σκεφτείτε τον Τομ Κρουζ να παίζει τον Iron Man – που δημιουργεί διασκεδαστικά βίντεο. Δυστυχώς, καθιστά επίσης δυνατή τη δημιουργία πορνογραφία χωρίς τη συγκατάθεση των ανθρώπων που απεικονίζονται. Μέχρι στιγμής, αυτοί οι άνθρωποι, σχεδόν όλες οι γυναίκες, είναι τα μεγαλύτερα θύματα όταν γίνεται κατάχρηση της τεχνολογίας deepfake.

Τα Deepfakes μπορούν επίσης να χρησιμοποιηθούν για τη δημιουργία βίντεο με πολιτικούς ηγέτες να λένε πράγματα που δεν είπαν ποτέ. Το Βελγικό Σοσιαλιστικό Κόμμα κυκλοφόρησε ένα χαμηλής ποιότητας μη ψεύτικο αλλά ακόμα ψεύτικο βίντεο του Ο Πρόεδρος Τραμπ προσβάλλει το Βέλγιο, το οποίο είχε αρκετή αντίδραση για να δείξει τους πιθανούς κινδύνους από βαθύτερα ψεύτικα υψηλής ποιότητας.

{vembed Y=poSd2CyDpyA}

Ο Hany Farid του Πανεπιστημίου της Καλιφόρνια στο Μπέρκλεϋ εξηγεί πώς γίνονται τα deepfakes.

Ισως πιο τρομακτικό από όλα, μπορούν να χρησιμοποιηθούν για τη δημιουργία αμφιβολίες για το περιεχόμενο των πραγματικών βίντεο, υποδεικνύοντας ότι θα μπορούσαν να είναι deepfakes.

Λαμβάνοντας υπόψη αυτούς τους κινδύνους, θα ήταν εξαιρετικά πολύτιμο να μπορούμε να ανιχνεύουμε τα βαθιά ψεύτικα και να τα επισημαίνουμε με σαφήνεια. Αυτό θα διασφάλιζε ότι τα ψεύτικα βίντεο δεν ξεγελούν το κοινό και ότι τα πραγματικά βίντεο μπορούν να ληφθούν ως αυθεντικά.

Εντοπισμός πλαστών

Η ανίχνευση του Deepfake ως πεδίο έρευνας ξεκίνησε λίγο πριν πριν από τρία χρόνια. Η πρώιμη εργασία επικεντρώθηκε στον εντοπισμό ορατών προβλημάτων στα βίντεο, όπως π.χ deepfakes που δεν αναβοσβήνουν. Με τον καιρό, ωστόσο, το τα ψεύτικα έχουν γίνει καλύτερα μιμούνται πραγματικά βίντεο και γίνονται πιο δύσκολο να εντοπιστούν τόσο για άτομα όσο και για εργαλεία ανίχνευσης.

Υπάρχουν δύο κύριες κατηγορίες έρευνας ανίχνευσης deepfake. Το πρώτο περιλαμβάνει κοιτάζοντας τη συμπεριφορά των ανθρώπων στα βίντεο. Ας υποθέσουμε ότι έχετε πολλά βίντεο με κάποιον διάσημο, όπως ο Πρόεδρος Ομπάμα. Η τεχνητή νοημοσύνη μπορεί να χρησιμοποιήσει αυτό το βίντεο για να μάθει τα μοτίβα του, από τις χειρονομίες του έως τις παύσεις του στην ομιλία. Τότε μπορεί παρακολουθήστε ένα deepfake του και παρατηρήστε πού δεν ταιριάζει με αυτά τα μοτίβα. Αυτή η προσέγγιση έχει το πλεονέκτημα ότι μπορεί να λειτουργεί ακόμα κι αν η ίδια η ποιότητα του βίντεο είναι ουσιαστικά τέλεια.

{vembed Y=gsv1OsCEad0}

Ο Aaron Lawson της SRI International περιγράφει μια προσέγγιση για τον εντοπισμό των deepfakes.

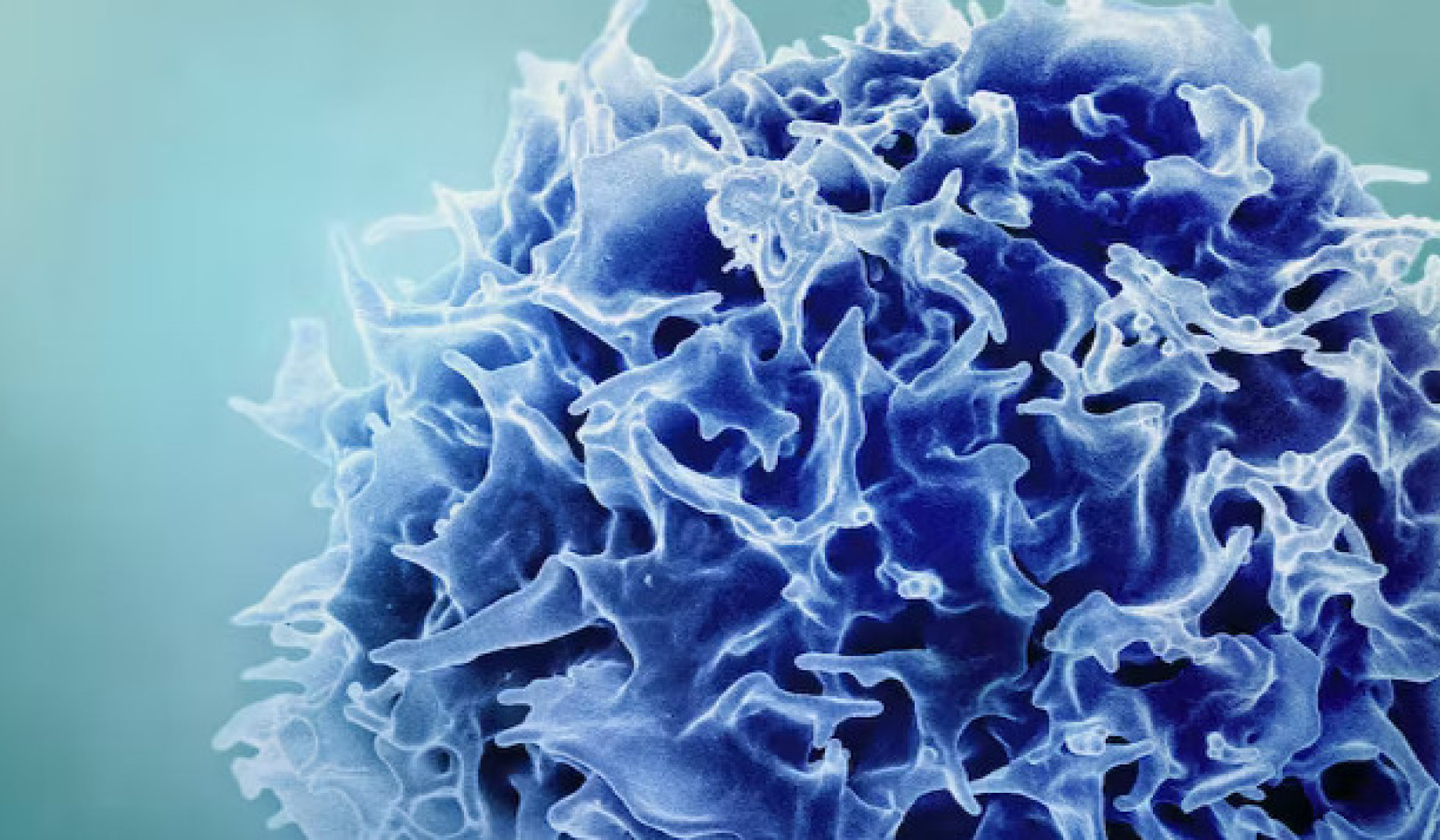

Άλλοι ερευνητές, συμπεριλαμβανομένης της ομάδας μας, έχουν επικεντρωθεί σε διαφορές ότι όλα τα deepfakes έχουν σε σύγκριση με αληθινά βίντεο. Τα Deepfake βίντεο δημιουργούνται συχνά με τη συγχώνευση πλαισίων που δημιουργούνται μεμονωμένα για να σχηματιστούν βίντεο. Λαμβάνοντας αυτό υπόψη, οι μέθοδοι της ομάδας μας εξάγουν τα βασικά δεδομένα από τα πρόσωπα σε μεμονωμένα καρέ ενός βίντεο και στη συνέχεια τα παρακολουθούν μέσω συνόλων ταυτόχρονων καρέ. Αυτό μας επιτρέπει να ανιχνεύουμε ασυνέπειες στη ροή των πληροφοριών από το ένα πλαίσιο στο άλλο. Χρησιμοποιούμε παρόμοια προσέγγιση και για το σύστημα ανίχνευσης ψεύτικου ήχου.

Αυτές οι λεπτές λεπτομέρειες είναι δύσκολο να τις δουν οι άνθρωποι, αλλά δείχνουν πόσο τα deepfakes δεν είναι αρκετά τέλειο ακόμα. Ανιχνευτές όπως αυτοί μπορούν να λειτουργήσουν για οποιοδήποτε άτομο, όχι μόνο για λίγους παγκόσμιους ηγέτες. Στο τέλος, μπορεί να χρειαστούν και οι δύο τύποι ανιχνευτών deepfake.

Τα πρόσφατα συστήματα ανίχνευσης έχουν πολύ καλή απόδοση σε βίντεο που έχουν συλλεχθεί ειδικά για την αξιολόγηση των εργαλείων. Δυστυχώς, ακόμη και τα καλύτερα μοντέλα το κάνουν κακώς σε βίντεο που βρέθηκαν στο διαδίκτυο. Η βελτίωση αυτών των εργαλείων ώστε να είναι πιο ισχυρά και χρήσιμα είναι το βασικό επόμενο βήμα.

Ποιος πρέπει να χρησιμοποιεί ανιχνευτές deepfake;

Στην ιδανική περίπτωση, ένα εργαλείο επαλήθευσης deepfake θα πρέπει να είναι διαθέσιμο σε όλους. Ωστόσο, αυτή η τεχνολογία βρίσκεται στα αρχικά στάδια ανάπτυξης. Οι ερευνητές πρέπει να βελτιώσουν τα εργαλεία και να τα προστατεύσουν από τους χάκερ πριν τα κυκλοφορήσουν ευρέως.

Ταυτόχρονα, όμως, τα εργαλεία για τη δημιουργία deepfakes είναι διαθέσιμα σε όποιον θέλει να ξεγελάσει το κοινό. Το να κάθεσαι στο περιθώριο δεν είναι επιλογή. Για την ομάδα μας, η σωστή ισορροπία ήταν η συνεργασία με τους δημοσιογράφους, γιατί αυτοί αποτελούν την πρώτη γραμμή άμυνας ενάντια στη διάδοση της παραπληροφόρησης.

Πριν δημοσιεύσουν ιστορίες, οι δημοσιογράφοι πρέπει να επαληθεύσουν τις πληροφορίες. Έχουν ήδη δοκιμασμένες και αληθινές μεθόδους, όπως έλεγχος με πηγές και να ζητήσουν περισσότερα από ένα άτομα να επαληθεύσουν βασικά γεγονότα. Έτσι, αφήνοντας το εργαλείο στα χέρια τους, τους δίνουμε περισσότερες πληροφορίες και γνωρίζουμε ότι δεν θα βασιστούν μόνο στην τεχνολογία, δεδομένου ότι μπορεί να κάνει λάθη.

Μπορούν οι ανιχνευτές να κερδίσουν τον αγώνα των εξοπλισμών;

Είναι ενθαρρυντικό να βλέπεις ομάδες από Facebook και Microsoft επενδύοντας στην τεχνολογία για την κατανόηση και τον εντοπισμό των deepfakes. Αυτός ο τομέας χρειάζεται περισσότερη έρευνα για να συμβαδίσει με την ταχύτητα των εξελίξεων στην τεχνολογία deepfake.

Οι δημοσιογράφοι και οι πλατφόρμες μέσων κοινωνικής δικτύωσης πρέπει επίσης να καταλάβουν πώς να προειδοποιούν καλύτερα τους ανθρώπους για τα deepfakes όταν εντοπίζονται. Έρευνες το έχουν δείξει οι άνθρωποι θυμούνται το ψέμα, αλλά όχι το γεγονός ότι ήταν ψέμα. Θα ισχύει το ίδιο και για τα ψεύτικα βίντεο; Η απλή τοποθέτηση του "Deepfake" στον τίτλο μπορεί να μην είναι αρκετή για να αντιμετωπίσει κάποια είδη παραπληροφόρησης.

Τα Deepfakes είναι εδώ για να μείνουν. Η διαχείριση της παραπληροφόρησης και η προστασία του κοινού θα είναι πιο δύσκολη από ποτέ, καθώς η τεχνητή νοημοσύνη γίνεται πιο ισχυρή. Είμαστε μέρος μιας αναπτυσσόμενης ερευνητικής κοινότητας που αντιμετωπίζει αυτήν την απειλή, στην οποία η ανίχνευση είναι μόνο το πρώτο βήμα.![]()

Σχετικά με τους Συγγραφείς

John Sohrawardi, Διδάκτορας στις Επιστήμες Υπολογιστών και Πληροφορικής, Rochester Institute of Technology και Matthew Wright, καθηγητής Ασφάλειας Υπολογιστών, Rochester Institute of Technology

Αυτό το άρθρο αναδημοσιεύθηκε από το Η Συνομιλία υπό την άδεια Creative Commons. Διαβάστε το πρωτότυπο άρθρο.