Δεν ξυπνήσαμε μια μέρα και παραδώσαμε τα ηνία στα μηχανήματα. Συνέβη ήσυχα, με μια ευκολία τη φορά. Το email σας ταξινομήθηκε από μόνο του. Το ημερολόγιό σας έμαθε να προτείνει ώρες συναντήσεων. Η τράπεζά σας είχε ήδη επισημάνει την απάτη πριν παρατηρήσετε τη χρέωση. Αυτές οι αναβαθμίσεις φάνηκαν χρήσιμες, όχι μεταφορές ισχύος. Αλλά κάτι άλλαξε στην πορεία και οι περισσότεροι από εμάς το χάσαμε.

Σε αυτό το άρθρο

- Κατανόηση του τι είναι στην πραγματικότητα οι πράκτορες τεχνητής νοημοσύνης και πώς διαφέρουν από το κανονικό λογισμικό

- Η κρίσιμη διαφορά μεταξύ βοήθειας και ανάθεσης σε αυτοματοποιημένα συστήματα

- Γιατί η βελτιστοποίηση χωρίς σοφία δημιουργεί προβλέψιμα προβλήματα

- Παραδείγματα από τον πραγματικό κόσμο τόσο για την ηθική χρήση όσο και για τις αναδυόμενες καταχρήσεις

- Πρακτικά βήματα για να διατηρήσετε το πρακτορείο σας σε έναν αυτοματοποιημένο κόσμο

Τα συστήματα που τώρα ταξινομούν, προτείνουν και μερικές φορές αποφασίζουν για εμάς ξεκίνησαν ως απλοί βοηθοί. Τα φίλτρα ανεπιθύμητης αλληλογραφίας μας έσωσαν από ατελείωτα ανεπιθύμητα μηνύματα. Οι μηχανές συστάσεων μας οδήγησαν σε βιβλία που ίσως να μας άρεσαν. Οι βοηθοί προγραμματισμού βρήκαν ώρες που λειτουργούσαν για όλους. Κάθε καινοτομία έλυνε ένα πραγματικό πρόβλημα. Καθεμία έκανε τη ζωή ελαφρώς ευκολότερη. Και η καθεμία μας εκπαίδευσε να περιμένουμε ότι η τεχνολογία θα χειριζόταν ολοένα και πιο σύνθετες κρίσεις για λογαριασμό μας.

Βρισκόμαστε τώρα σε ένα σημείο όπου τα συστήματα δεν μας βοηθούν απλώς να αποφασίσουμε - αποφασίζουν και ενεργούν. Δεν περιμένουν την έγκριση. Δεν εξηγούν πάντα τον εαυτό τους. Και λειτουργούν σε κλίμακες και ταχύτητες που κάνουν την ανθρώπινη εποπτεία να φαίνεται γραφική, ακόμη και αδύνατη. Αυτό δεν συνέβη επειδή κάναμε μια μεγάλη επιλογή να παραδώσουμε τον έλεγχο. Συνέβη επειδή κάναμε δέκα χιλιάδες μικρές επιλογές για να αποδεχτούμε την ευκολία χωρίς να αμφισβητήσουμε το κόστος.

Τι κάνουν στην πραγματικότητα αυτά τα συστήματα

Ένας πράκτορας Τεχνητής Νοημοσύνης είναι διαφορετικός από το λογισμικό με το οποίο μεγαλώσατε. Τα παραδοσιακά προγράμματα ακολουθούν οδηγίες. Περιμένουν την εισαγωγή δεδομένων, την επεξεργάζονται σύμφωνα με σταθερούς κανόνες και σταματούν. Μια αριθμομηχανή δεν συνεχίζει να υπολογίζει αφού φύγετε. Ένας επεξεργαστής κειμένου δεν ξεκινά να γράφει μόνος του. Αυτά τα εργαλεία είναι αδρανή μέχρι να ενεργοποιηθούν. Είναι υπηρέτες, όχι ηθοποιοί.

Οι πράκτορες Τεχνητής Νοημοσύνης λειτουργούν διαφορετικά. Παρατηρούν συνεχώς το περιβάλλον τους. Λαμβάνουν αποφάσεις με βάση αυτά που αντιλαμβάνονται. Αναλαμβάνουν δράσεις για την επίτευξη στόχων. Και επαναλαμβάνουν αυτόν τον κύκλο χωρίς συνεχή ανθρώπινη κατεύθυνση. Το καθοριστικό χαρακτηριστικό δεν είναι η νοημοσύνη με την ανθρώπινη έννοια - είναι η πρωτοβουλία. Ένας πράκτορας δεν ανταποκρίνεται απλώς όταν καλείται. Λειτουργεί.

Σκεφτείτε έναν θερμοστάτη. Ο παλιός τύπος απαιτούσε να τον ρυθμίζετε χειροκίνητα όταν άλλαζε η θερμοκρασία. Ένας έξυπνος θερμοστάτης παρατηρεί μοτίβα, μαθαίνει τις προτιμήσεις σας, προβλέπει το πρόγραμμά σας και προσαρμόζει μόνος του τη θέρμανση και την ψύξη. Λαμβάνει αποφάσεις. Μικρές, αλλά παρόλα αυτά αποφάσεις. Τώρα, κλιμακώστε το σε συστήματα που διαπραγματεύονται μετοχές, φιλτράρουν αιτήσεις εργασίας, εποπτεύουν περιεχόμενο και διαχειρίζονται αλυσίδες εφοδιασμού. Η αρχή είναι η ίδια. Οι συνέπειες όχι.

Η διαφορά μεταξύ βοήθειας και αντικατάστασης

Υπάρχει ένα ηθικό σημείο καμπής στον αυτοματισμό που οι περισσότερες συζητήσεις παραβλέπουν. Είναι η διαφορά μεταξύ της χρήσης της Τεχνητής Νοημοσύνης για να εμπλουτίσετε την κρίση σας και της άφησης της Τεχνητής Νοημοσύνης να την αντικαταστήσει. Το ένα σας κρατά υπεύθυνους. Το άλλο σας απαλλάσσει από κάθε ευθύνη.

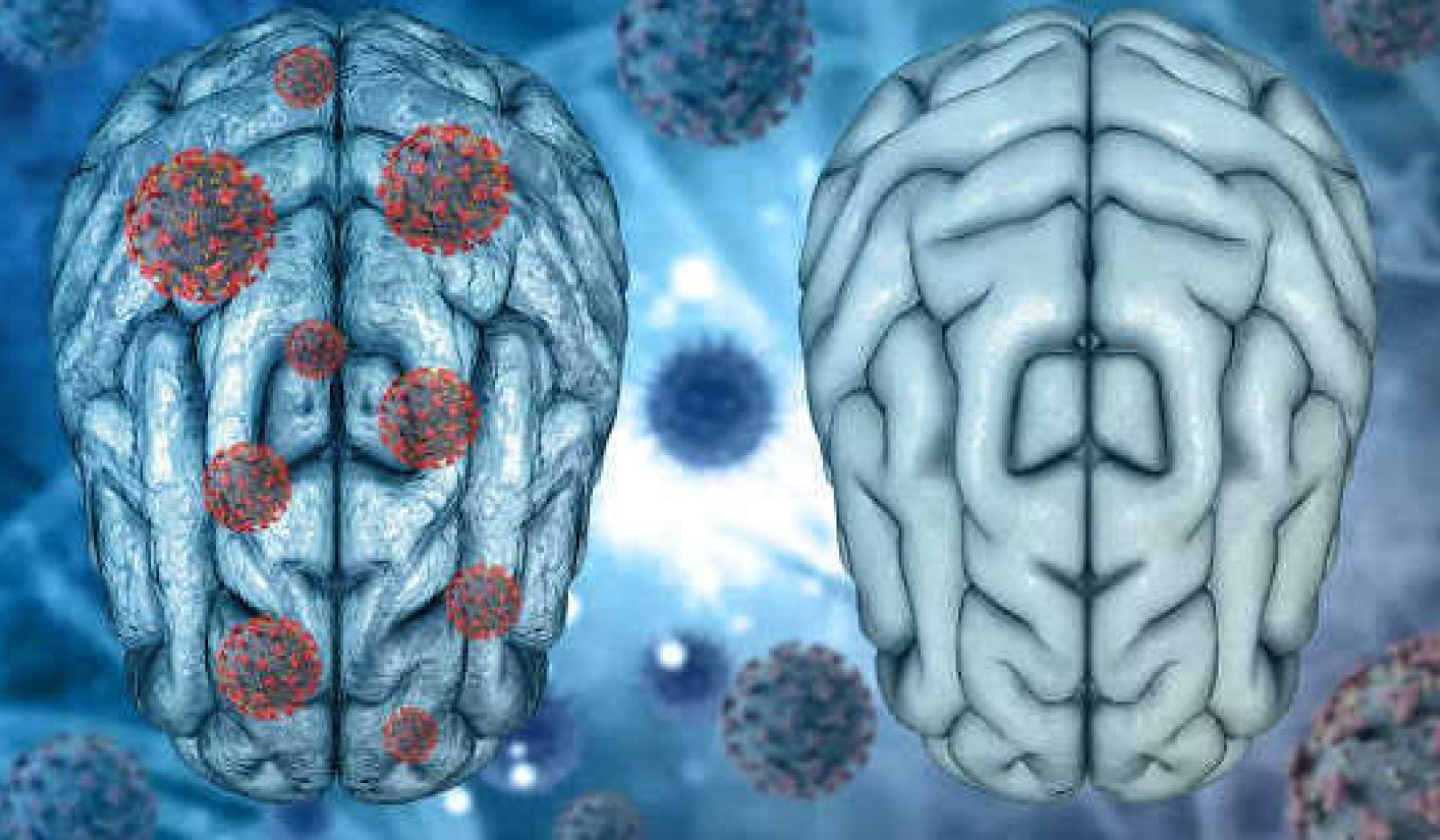

Όταν ένας γιατρός χρησιμοποιεί ένα σύστημα τεχνητής νοημοσύνης για να αναλύσει ιατρικές εικόνες, αλλά εξακολουθεί να εξετάζει τα αποτελέσματα και να κάνει τη διάγνωση, αυτό ονομάζεται επαύξηση. Το εργαλείο αναδεικνύει μοτίβα που ο άνθρωπος μπορεί να μην έχει κατανοήσει. Ο άνθρωπος ενσωματώνει αυτά τα ευρήματα με το ιστορικό, τα συμπτώματα και την κλινική εμπειρία του ασθενούς. Η ευθύνη παραμένει σαφής. Αλλά όταν μια ασφαλιστική εταιρεία χρησιμοποιεί έναν αλγόριθμο για να εγκρίνει ή να απορρίψει αξιώσεις, και οι ανθρώπινοι κριτές γίνονται σφραγίδες που σπάνια ανατρέπουν τις συστάσεις του συστήματος, κάτι σημαντικό έχει αλλάξει. Η εμφάνιση της ανθρώπινης εποπτείας καλύπτει αυτό που ουσιαστικά είναι αλγοριθμική εξουσία.

Η ανάθεση αρμοδιοτήτων δίνει την αίσθηση της αποτελεσματικότητας. Δίνει την αίσθηση της ουδέτερης. Δίνει την αίσθηση της προόδου. Άλλωστε, γιατί οι άνθρωποι να αφιερώνουν χρόνο σε αποφάσεις που οι μηχανές μπορούν να διαχειριστούν πιο γρήγορα και με μεγαλύτερη συνέπεια; Η απάντηση είναι ότι η συνέπεια δεν είναι το ίδιο με την ορθότητα και η αποτελεσματικότητα δεν είναι το ίδιο με τη δικαιοσύνη. Οι μηχανές δεν έχουν καμία επιρροή. Δεν χάνουν τον ύπνο τους για λάθη. Όταν αναθέτουμε την κρίση σε συστήματα που δεν έχουν κρίση, δημιουργούμε ένα κενό λογοδοσίας. Και αυτό το κενό γεμίζει με δικαιολογίες. Ο αλγόριθμος το έκανε. Το σύστημα το σημείωσε. Αυτές οι φράσεις έχουν γίνει ασπίδες κατά της ευθύνης.

Γιατί η αδιάκοπη βελτιστοποίηση μας αποτυγχάνει

Οι πράκτορες της Τεχνητής Νοημοσύνης είναι βελτιστοποιητές. Τους δίνονται στόχοι και τους επιδιώκουν αδιάκοπα, συχνά πολύ πιο αποτελεσματικά από ό,τι θα μπορούσαν οι άνθρωποι. Αυτό ακούγεται σαν πλεονέκτημα μέχρι να δούμε τι βελτιστοποιείται στην πραγματικότητα. Οι αλγόριθμοι των μέσων κοινωνικής δικτύωσης βελτιστοποιούν την αλληλεπίδραση, πράγμα που στην πράξη σημαίνει ενίσχυση της οργής και της διαμάχης, επειδή αυτά κρατούν τους ανθρώπους σε εγρήγορση. Οι αλγόριθμοι προσλήψεων βελτιστοποιούν τα μοτίβα σε προηγούμενες επιτυχημένες προσλήψεις, πράγμα που σημαίνει ότι αναπαράγουν ιστορικές προκαταλήψεις. Οι αλγόριθμοι τιμολόγησης βελτιστοποιούν τα έσοδα, πράγμα που μπορεί να σημαίνει ότι διαφορετικά άτομα πληρώνουν διαφορετικές τιμές για το ίδιο προϊόν με βάση το πόσο πιστεύει το σύστημα ότι θα ανεχθεί.

Το πρόβλημα δεν είναι ότι αυτά τα συστήματα είναι προβληματικά. Είναι ότι λειτουργούν ακριβώς όπως έχουν σχεδιαστεί. Κάνουν αυτό που τους είπαν να κάνουν. Αλλά οι στόχοι που τους δόθηκαν είναι ελλιπείς. Δεν λαμβάνουν υπόψη την αλήθεια, τη δικαιοσύνη, την αξιοπρέπεια ή τη μακροπρόθεσμη ευημερία, επειδή αυτά τα πράγματα είναι δύσκολο να μετρηθούν και ακόμη πιο δύσκολο να κωδικοποιηθούν. Έτσι, τα συστήματα μεγιστοποιούν ό,τι μπορεί να μετρηθεί - κλικ, μετατροπές, αποδοτικότητα, κέρδος - και τα πράγματα που έχουν τη μεγαλύτερη σημασία αντιμετωπίζονται ως εξωτερικότητες.

Οι άνθρωποι υποτίθεται ότι είναι αυτοί που ζυγίζουν το πλαίσιο και τις αξίες. Υποτίθεται ότι πρέπει να παρατηρούμε πότε η βελτιστοποίηση δημιουργεί βλάβη. Αλλά όταν τα συστήματα λειτουργούν σε κλίμακα και ταχύτητα, αυτή η ανθρώπινη κρίση καθίσταται μη πρακτική. Μέχρι να παρατηρήσουμε ότι κάτι δεν πάει καλά, ο αλγόριθμος έχει ήδη λάβει δέκα χιλιάδες αποφάσεις. Αυτό που μπορεί να βελτιστοποιηθεί δεν είναι πάντα αυτό που πρέπει να μεγιστοποιηθεί. Αυτή είναι μια αλήθεια που οι μηχανές δεν μπορούν να κατανοήσουν και οι άνθρωποι συνεχίζουν να ξεχνούν.

Πώς γίνεται κακή χρήση αυτών των συστημάτων

Το μεγαλύτερο μέρος της βλάβης από πράκτορες Τεχνητής Νοημοσύνης δεν προέρχεται από κακόβουλη πρόθεση. Προέρχεται από ανεξέλεγκτα συστήματα που κάνουν ακριβώς αυτό που έχουν προγραμματιστεί να κάνουν, σε κλίμακες και ταχύτητες που μεγεθύνουν κάθε ελάττωμα. Ένας άνθρωπος που ενεργεί ανήθικα είναι πρόβλημα. Ένα σύστημα που επιτρέπει σε έναν μόνο δράστη να λειτουργεί σαν να ήταν χιλιάδες είναι μια κρίση.

Η κλίμακα χωρίς λογοδοσία εμφανίζεται παντού. Bots που χειραγωγούν τις συνομιλίες στα μέσα κοινωνικής δικτύωσης, συστήματα ψεύτικων κριτικών, αυτοματοποιημένο spam που προσαρμόζεται πιο γρήγορα από ό,τι μπορούν να το εντοπίσουν τα φίλτρα. Όταν έρχονται οι συνέπειες, η άμυνα είναι πάντα η ίδια: το σύστημα το έκανε. Απλώς όρισα τις παραμέτρους. Αυτές οι δικαιολογίες λειτουργούν επειδή η λογοδοσία έχει σκόπιμα συγκαλύψει.

Η ανάθεση βλάβης είναι ιδιαίτερα ύπουλη επειδή επιτρέπει στα ιδρύματα να αποφεύγουν την ευθύνη ενώ παράλληλα ασκούν εξουσία. Ένας αλγόριθμος απορρίπτει την αίτησή σας για δάνειο. Ένα αυτοματοποιημένο σύστημα επισημαίνει την ανάρτησή σας ως παραβίαση των κοινοτικών προτύπων. Ένα εργαλείο πρόσληψης σας ελέγχει πριν καν δει κάποιος άνθρωπος το βιογραφικό σας. Όταν κάνετε έφεση, συχνά σας λένε ότι η απόφαση ισχύει επειδή το σύστημα είναι δίκαιο και αντικειμενικό. Αλλά η δικαιοσύνη δεν είναι το ίδιο με τη συνέπεια και η αντικειμενικότητα είναι μύθος όταν το σύστημα έχει εκπαιδευτεί με βάση μεροληπτικά δεδομένα ή έχει σχεδιαστεί για να βελτιστοποιεί λάθος στόχους.

Ο βαθύτερος κίνδυνος

Ο πραγματικός κίνδυνος δεν είναι ότι οι μηχανές θα πάρουν τον έλεγχο. Είναι ότι θα σταματήσουμε να προσπαθούμε. Οι άνθρωποι προσαρμόζονται στα συστήματα γύρω τους. Όταν οι αποφάσεις φαίνονται αυτοματοποιημένες και αναπόφευκτες, η αμφισβήτηση εξασθενεί. Όταν τα αποτελέσματα φτάνουν χωρίς ορατή ανθρώπινη συμμετοχή, η ευθύνη φαίνεται να εξατμίζεται. Εκπαιδεύουμε τους εαυτούς μας να αποδεχόμαστε αυτό που μας δίνεται αντί να απαιτούμε αυτό που είναι σωστό.

Αυτό το μοτίβο είναι οικείο. Η γραφειοκρατία διδάσκει στους ανθρώπους ότι οι κανόνες είναι σταθεροί και ότι δεν υπάρχουν εξαιρέσεις. Τα μονοπώλια πλατφορμών διδάσκουν στους ανθρώπους ότι οι όροι παροχής υπηρεσιών είναι αδιαπραγμάτευτοι. Ο χρηματοοικονομικός αυτοματισμός διδάσκει στους ανθρώπους ότι οι αγορές είναι πέρα από την ανθρώπινη επιρροή. Κάθε σύστημα καταρρίπτει την αίσθηση ότι η ατομική επιλογή έχει σημασία. Και οι πράκτορες της Τεχνητής Νοημοσύνης, επειδή λειτουργούν ταχύτερα και πιο αδιαφανώς από οτιδήποτε πριν από αυτούς, επιταχύνουν αυτή τη διαδικασία.

Η αυτονομία δεν είναι μια προεπιλεγμένη κατάσταση. Είναι κάτι που είτε εξασκείς είτε χάνεις. Όσο πιο συχνά υποτάσσεσαι σε συστήματα, τόσο λιγότερο ικανός γίνεσαι να διεκδικήσεις τη δική σου κρίση. Όσο πιο συχνά αποδέχεσαι τα αλγοριθμικά αποτελέσματα χωρίς αμφιβολία, τόσο πιο δύσκολο γίνεται να φανταστείς ότι τα πράγματα θα μπορούσαν να είναι διαφορετικά. Αυτός είναι ο μεγαλύτερος κίνδυνος. Όχι ο έλεγχος από μηχανές, αλλά η συνήθεια να μην αποφασίζεις.

Τι μπορείτε πραγματικά να κάνετε

Η αντίσταση στη διάβρωση της αυτονομίας δεν απαιτεί μεγαλεπήβολες χειρονομίες. Απαιτεί καθημερινή εξάσκηση. Ξεκινήστε αμφισβητώντας τον αόρατο αυτοματισμό. Όταν ένα σύστημα λαμβάνει μια απόφαση που σας επηρεάζει, ρωτήστε πώς λειτουργεί και ποιος είναι υπεύθυνος. Πριν εμπιστευτείτε τα αυτοματοποιημένα αποτελέσματα, ρωτήστε αν το αποτέλεσμα έχει νόημα και αν το σύστημα μπορεί να παραλείπει κάτι σημαντικό. Προτιμήστε συστήματα που εξηγούν τον εαυτό τους έναντι των μαύρων κουτιών που απαιτούν εμπιστοσύνη.

Μείνετε ενεργοί όπου έχει σημασία. Μην αναθέτετε αποφάσεις μόνο και μόνο επειδή μπορείτε. Εάν ένα εργαλείο προσφέρεται να γράψει τα email σας, να επεξεργαστεί την εργασία σας ή να κάνει συστάσεις εκ μέρους σας, σκεφτείτε εάν η ευκολία αξίζει την απόσταση που δημιουργεί μεταξύ εσάς και της εργασίας. Και όταν συναντάτε συστήματα που λειτουργούν χωρίς λογοδοσία, απαιτήστε κάτι καλύτερο. Αποκρούστε τις αλγοριθμικές αποφάσεις. Ζητήστε ανθρώπινη αξιολόγηση. Αρνηθείτε να αποδεχτείτε ότι η απάντηση του συστήματος είναι οριστική μόνο και μόνο επειδή είναι αυτοματοποιημένη.

Η αυτονομία είναι μια πρακτική, όχι μια προεπιλεγμένη ρύθμιση. Κάθε φορά που αμφισβητείτε ένα αυτοματοποιημένο αποτέλεσμα, ασκείτε μια ικανότητα που ατροφεί από την αχρησία. Κάθε φορά που επιμένετε στην ανθρώπινη λογοδοσία, αντιδρείτε στην ομαλοποίηση της αλγοριθμικής εξουσίας. Αυτές οι μικρές πράξεις συνειδητής επιλογής έχουν σημασία επειδή διαμορφώνουν το περιβάλλον στο οποίο πλοηγούνται όλοι οι άλλοι.

Εργαλεία που διαμορφώνουμε ή δυνάμεις που μας διαμορφώνουν

Οι πράκτορες τεχνητής νοημοσύνης είναι εργαλεία που σχεδιάζουμε. Αυτή είναι η πρώτη αλήθεια. Αλλά μόλις αναπτυχθούν, αναδιαμορφώνουν τη συμπεριφορά και την εξουσία. Αυτή είναι η δεύτερη αλήθεια. Και τα δύο είναι πραγματικά, και το να προσποιούμαστε το αντίθετο είναι επικίνδυνο. Το ερώτημα δεν είναι αν αυτά τα συστήματα θα συνεχίσουν να ενεργούν. Θα συνεχίσουν. Το ερώτημα είναι αν οι άνθρωποι θα παραμείνουν υπόλογοι για ό,τι ενεργεί στο όνομά τους.

Το μέλλον χτίζεται αυτή τη στιγμή μέσα από ένα εκατομμύριο μικρές αποφάσεις σχετικά με το πού θα αυτοματοποιηθεί και πού θα επιμείνει στην ανθρώπινη κρίση. Αυτές οι αποφάσεις δεν είναι απλώς τεχνικές. Είναι ηθικές. Αφορούν το είδος του κόσμου στον οποίο είμαστε διατεθειμένοι να ζήσουμε και το είδος της υπηρεσίας που είμαστε διατεθειμένοι να διατηρήσουμε. Η προεπιλεγμένη πορεία είναι σαφής. Περισσότερος αυτοματισμός, λιγότερη εποπτεία, μεγαλύτερη ευκολία, μειωμένη ευθύνη. Αυτή η πορεία είναι εύκολη επειδή είναι κερδοφόρα και αποτελεσματική και φαίνεται αναπόφευκτη.

Αλλά το αναπόφευκτο είναι μια ιστορία που λέμε στον εαυτό μας για να αποφύγουμε την ταλαιπωρία της επιλογής. Η πραγματικότητα είναι ότι κάθε ανάπτυξη ενός παράγοντα Τεχνητής Νοημοσύνης είναι μια επιλογή. Κάθε αποδοχή της αλγοριθμικής εξουσίας είναι μια επιλογή. Κάθε φορά που σηκώνουμε τους ώμους μας και λέμε ότι το σύστημα αποφάσισε είναι μια επιλογή. Και κάθε επιλογή διαμορφώνει αυτό που θα ακολουθήσει. Επομένως, το ερώτημα δεν είναι τι θα κάνει η Τεχνητή Νοημοσύνη. Το ερώτημα είναι ποιες αποφάσεις είστε ακόμα διατεθειμένοι να πάρετε οι ίδιοι. Η απάντηση σε αυτό το ερώτημα έχει μεγαλύτερη σημασία από οποιονδήποτε αλγόριθμο.

Σχετικά με το Συγγραφέας

Ο Alex Jordan είναι συγγραφέας προσωπικού για το InnerSelf.com

Προτεινόμενα Βιβλία

Το πρόβλημα ευθυγράμμισης: Μηχανική μάθηση και ανθρώπινες αξίες

Μια εις βάθος ερευνημένη διερεύνηση του πώς τα συστήματα Τεχνητής Νοημοσύνης μαθαίνουν αξίες και γιατί η ευθυγράμμισή τους με την ανθρώπινη ευημερία είναι πολύ πιο περίπλοκη από ό,τι αντιλαμβάνονται οι περισσότεροι άνθρωποι.

Όπλα Καταστροφής των Μαθηματικών: Πώς τα Μεγάλα Δεδομένα Αυξάνουν την Ανισότητα και Απειλούν τη Δημοκρατία

Μια προσιτή εξέταση του πώς οι αλγόριθμοι εδραιώνουν την ανισότητα και λειτουργούν χωρίς λογοδοσία, γραμμένη από μια μαθηματικό που εργάστηκε μέσα στα συστήματα που επικρίνει.

Αυτοματοποίηση της Ανισότητας: Πώς τα Εργαλεία Υψηλής Τεχνολογίας Προσδιορίζουν, Αστυνομεύουν και Τιμωρούν τους Φτωχούς

Μια ισχυρή έρευνα σχετικά με το πώς τα αυτοματοποιημένα συστήματα στοχεύουν και τιμωρούν τους φτωχούς, αποκαλύπτοντας το ανθρώπινο κόστος της αλγοριθμικής λήψης αποφάσεων στις δημόσιες υπηρεσίες.

Ανακεφαλαίωση άρθρου

Οι πράκτορες της Τεχνητής Νοημοσύνης αντιπροσωπεύουν μια μετατόπιση από εργαλεία που βοηθούν την ανθρώπινη κρίση σε συστήματα που την αντικαθιστούν, λειτουργώντας με πρωτοβουλία και αυτονομία σε ταχύτητες που δυσχεραίνουν την εποπτεία. Ο πραγματικός κίνδυνος δεν είναι η μηχανική νοημοσύνη, αλλά η σταδιακή διάβρωση της ανθρώπινης δράσης καθώς προσαρμοζόμαστε στην αυτοματοποιημένη λήψη αποφάσεων χωρίς λογοδοσία. Η ηθική χρήση απαιτεί να διατηρούνται οι άνθρωποι υπεύθυνοι για τις επακόλουθες αποφάσεις, να διατηρείται η διαφάνεια και να αναγνωρίζεται ότι η βελτιστοποίηση χωρίς σοφία δημιουργεί προβλέψιμη βλάβη.

#ΠράκτορεςΤΝ #αυτοματοποίηση #ανθρώπινηΠράξη #αλγοριθμικήΛογοδοσία #ηθικήΤΝ #ψηφιακήαυτονομία #τεχνοηθική